機器之心原創

作者:吳昕

翻車是真的,希望也是真的。

香港中文大學的一處山間小道,流水小橋,樹影斑駁,青苔攀附在陡峭連綿的石梯上。

無人機視野下500 米的定向越野路線。

一只人形機器人跨過三十度的小橋,走上一段石路,邁過兩段臺階。好不容易來到一個九十度的彎,重心一歪,仰面倒下。

全程 500 米的定向越野,它只能走完開頭。

到了90度分叉路口,就躺平罷工。

第二天,它又出現在大學的嶺南體育場,嘗試戶外分揀垃圾。

草地禿嚕,每一步都像踩進人生陷阱,還沒碰到桌上的垃圾,就撲通倒地。

在第五屆 ATEC 科技精英賽——全球首個全自主、全真實戶外場景的機器人競技場上,類似畫面不斷上演。離開遙控器、走到戶外,機器人還能不能工作?

其實,跳舞、空翻、端咖啡,這些「展臺神跡」從來不是真實水平。離開溫室和遙控器,一塊禿草地、一只普通水壺就能瞬間「放倒」它們。

1X NEO,別說讓它親手洗碗了,就連把干干凈凈的鍋碗瓢盆放進洗碗機里,都挺艱難。

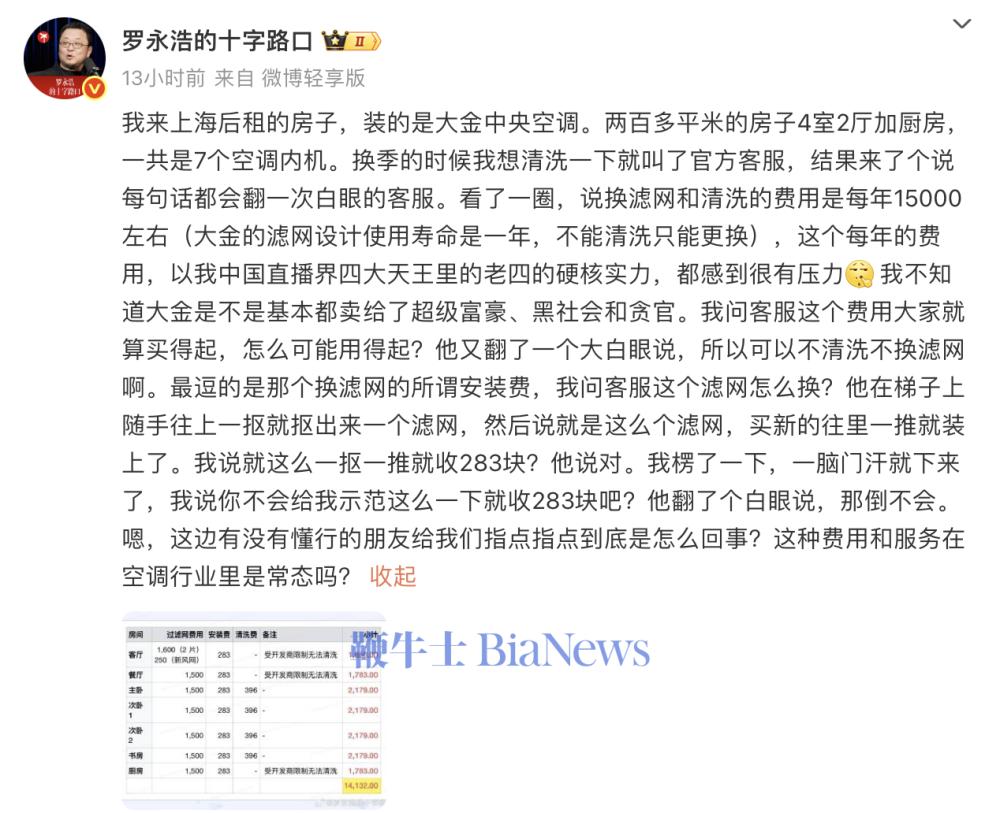

過去兩三年,人們普遍高估了人形機器人的通用能力。很多人喊著,它們將走進家庭,承擔家務,「這個事情絕對是高估的。」 ATEC 2025 專家委員會主席、香港工程院院士劉云輝認為,「五年之內實現都相當困難。」

但「丟掉遙控器」并不是未來加分項,而是具身智能能否真正落地的必選項

一些選手表示,機器人應該去做「人做不了或不該做的事」,在這些場景里,沒人能用遙控器替機器人做判斷。

必須丟掉遙控器,也不是太難。劉云輝認為,從技術路徑上看,感知與決策是關鍵。機器人能不能正確看到世界?能不能自己決定下一步怎么做?

劉云輝院士(左)在觀看自主澆花的比賽。

感知之困

為了理解并與三維世界溝通、互動,人類花費 5.4 億年進化出感知智能。如今,它正困擾著具身智能。在嶺南體育場,陽光成了機器人頻繁翻車的罪魁禍首。

早上七點場地還籠罩在陰影中,一小時后光照明顯增強,到了中午,陽光直射,連人類選手都看不清電腦屏幕。

深度相機(如 RealSense)的主動光結構在強光下幾乎失效:透明的礦泉水瓶在機器人眼里宛隱身,機械臂照常伸過去,結果直接把水瓶撞掉。

終于抓住啦。

澆花任務同樣困難重重。黃色水壺被曬得發白,白色桌面又強烈反光,導致點云嚴重散射,抓取動作屢屢失敗。而在 3D 識別中,那 6 朵形狀不規則的白色假花,本身就是高難度目標。原本規劃自主完成的隊伍,無奈選擇遙操。

選手遙操人形機器人拿水壺。

吊橋穿越也不省心。視覺定位被陽光帶偏,機器人一步步靠近吊橋邊沿,踩空跌落。

機器人走偏后,踩空,掉下橋。

如今,機器人的移動、視覺和導航都令人驚嘆,但操作能力依然相對原始。英國皇家工程院院士、意大利技術研究院(IIT)創始人、IEEE會士 Darwin Caldwell 說。

為什么操作如此難?因為,移動的底層難題,本質上就是「站穩 + 邁步」。涉及的物理變量較為固定,也能在仿真中完整構建,大規模強化學習因此收斂迅速,進展飛快。

操作任務涉及的變量,卻極其復雜——

透明與反光、材質差異、顏色變化、光照波動,哪怕只是抓香蕉和抓礦泉水瓶,對機器人來說都是完全不同的任務。

更關鍵的是,機器人目前缺乏真實的物理信息,觸覺反饋幾乎為零。而在人類操作行為中,觸覺和視覺同樣重要。

這也是為何 ATEC 會在垃圾分揀任務中選擇玩具香蕉:軟、可變形,但不會被機器人捏爛。

盡管如此,仍有兩支四足機器人隊伍像是開了掛,全自主「通關」垃圾分揀與吊橋穿越。

分揀任務中,浙江大學 wongtsai 賽隊沒有依賴大模型,而是回到 「傳統視覺 + 幾何」的老牌路線,并打磨到極致。

吊橋穿越之前,他們就在模擬器里高度還原真實場景:不僅復刻吊橋結構,還模擬了 RealSense 在戶外可能遇到的各類噪聲(視差誤差、散斑點云、紋理缺失等),sim2real 部署很順利。

智能決策之難:20 歲身體,3 歲智商

不少機器人從業者都說過類似扎心的真話。

在開放環境下,讓機器人自主從桌上拿瓶水都很難。稍微復雜一點的操作,全靠遙操或同構臂。

但我們想外包出去的家務,哪一件不是長鏈任務 + 工具使用的組合?做早餐不是煎個雞蛋,而是一套流程:找鍋 → 開火 → 備料 → 下鍋 → 裝盤 → 洗碗……

要讓機器人做這件事,它必須要有一個能規劃、會決策、有記憶的大腦。但多數機器人現在只有「20 歲身體,3 歲智商」。

ATEC2025 賽事組專家、松靈機器人具身智能部門負責人謝志強在直播里舉了個例子:掃地機。它能自主移動,但一旦被卡住,只會等待人類救援。

這也是為什么自主澆花會難倒一溜兒機器人,因為任務鏈實在太長了——

找到水壺 → 拿起 → 開水龍頭 → 接水 → 關龍頭 → 找花盆 → 澆花 → 放回原處

相比單步抓取、視覺分類,它考驗的是機器人是否真正具備長程任務的能力。結果,沒有機器人可以做到全自主。

浙江大學 wongtsai 賽隊告訴我們,實驗室里還能泛化的 VLA(視覺-語言-動作)模型,一旦到真實場景就不行了。

大模型能聽懂圖像和指令,但無法真正理解物理世界的細節,抓水壺、澆花,精度完全不夠。他們選擇了遙操。

浙江大學wongtsai賽隊通過遙操的方式完成了自主澆花的大部分子任務。

有的隊伍嘗試混合模式。先用遙控器把機器人挪到最佳位置,再讓機械臂自主完成抓壺、接水、澆花。

即便如此,一旦流程中某個環節出現異常,機器人的腦子就轉不過來了。

例如,手拿水壺打開水龍頭,萬一卡住,就會一直停在那里。

垃圾分揀里的道具香蕉,暴曬后會發生不可逆的形變,有的機器人明明已經夾住,卻仍堅持判定為失敗。

各出奇招,用水壺撞開水龍頭。

成績一度領先的機器人,也在定向越野最后一段失控:反復掉入同一處排水溝,無法自主調整,最終只能切回遙操。

最有意思的是,吊橋穿越。

機器人先跨過 5cm、10cm 的縫隙,最后迎面撞上一道 50cm 的間隙。

「機器人要自己做思考、做決策,比如拿起板來填充,從而改變環境,適應自己的運動。」 劉云輝解釋說,這不再是簡單的行走,而是包含了環境評估、工具使用、任務規劃的高級智能行為。

結果,四足機器人根本不考慮這些復雜操作,直接跳過去。

雙足機器人先靠物理外掛撐過前兩個小縫。到了 50cm 大間隙,多半會把拉繩碰掉,原地等救援。

各種物理外掛登場

這臺雙足機器人成功拿住了繩子,移動木板,邁過去了。

豪華的大模型,毛坯的硬件

和如今的主流路線一樣,今年參賽隊伍的系統架構大多采用「大模型 + 小模型」協同范式:

大模型負責高層語義理解、任務拆解與策略規劃;小模型面向前端感知、運動控制等即時執行;兩者再通過管線化與反饋回路完成閉環。

但隨之而來的現實問題是——

一臺機器人身上同時掛著 CPU、GPU、NPU 等一堆異構算力,怎么把它們擠進一塊體積足夠小、功耗足夠低的板子里,還能高效協同?

浙江大學 wongtsai 賽隊以全自主方式,出色完成了三項任務(包括定向越野)。其端側配置堪稱豪華。

他們給機器人掛了三臺小電腦,一臺 Intel NUC 當主控,兩塊英偉達算力板(一大一小)跑不同規模的神經網絡,比如用 Segment Anything 做圖像分割。

但要支撐更大規模模型推理,算力還是明顯不夠,延遲高、耗電大。

浙江大學wongtsai賽隊接受采訪,談到 15 萬美金獎金,隊長一句話總結:先還債,補貼昂貴設備成本。

隊伍成員也提到,要真正走向現實世界,機器人必須擁有順勢而為的自適應能力。定向越野時,腳和石頭不會硬碰硬;澆花時,身體會隨著水壺重量變化,實時調整重心。

這些都考驗著整機的力控能力與自適應控制。而想在復雜場景中做這種高質量感知和控制,目前的算力和本體都還差了一截。

「我們現在有一個巨大的問題,漂亮的算法無法在機器人內部運行。」ATEC2025 賽事組專家、卡里法大學(Khalifa University)自主機器人系統教授、機器人感知研究負責人 Jorge Manuel Miranda Dias 指出。要讓機器人的身體能承載其大腦的智能,低功耗、高性能的專用芯片和輕量化模型是關鍵。

翻車是真的,希望也是真的

有一件趣事。在比賽前,不少人認為機器人要全自主跑完定向越野,幾乎不可能。ATEC2025 賽事組專家、香港中文大學機械與自動化工程學系教授兼系主任、新加坡工程院院士陳本美甚至放下「豪言」,如果真有人做到,香港的餐廳任對方挑,他請客。

結果比賽第一天,就有兩臺四足機器人完成了全自主定向越野。

500 米級自然地形導航,信號差、多窄梯、多彎道、強光擾動……在成熟RL控制器支撐下,只依靠自身傳感器去構建地圖、完成定位、穩定前行。

劉云輝認為,機器人要真正進入人類世界,必須同時具備三大能力:能走、能操作、能改造環境。過去十年,四足機器人在「能走」這一維度已經有了質變。但「能操作、能改造環境」仍有巨大的研究空間。

相比四足機器人,雙足機器人和人形機器人還有更長的路要走。雙足形態重心高、支撐面小,平衡、力控、地形適應都遠比四足困難,更不用說在行走中完成操作。

它們面對的,是一個更陡峭、但也更貼近未來生活場景的技術坡度。

雙足、人形機器人面臨的挑戰,比四足機器人多得多。

翻車很正常,翻車也是一種進步。劉云輝說。沒有失敗,也就永遠沒有成功的可能。

也正因如此,ATEC 組委才會讓機器人面對真實世界的擾動。設計的每一道題,都不是為了讓它完成得好看,而是對這三大能力的系統級驗收,讓它在碰撞中暴露真正的弱點。

畢竟,只有真問題,才能讓行業知道下一步要突破什么。

AGI 的未來,注定是機器智能與物理世界的深度融合。作為賽事發起單位之一,螞蟻集團技術戰略部負責人表示,AI 必須從數據認知走向環境交互和行動執行,大家正期待下一次真正意義上的技術突破。

京公網安備 11011402013531號

京公網安備 11011402013531號