文 | 硅谷101

2025年10月底,meta AI部門宣布裁員600個職位,甚至核心部門的研究總監,同時掌管AI業務的高管紛紛離職、被邊緣化,就連圖靈獎得主Yann LeCun也被認為自身難保。

CNBC

一方面扎克伯格在用上億美元的年薪挖AI人才,但同時又如此決絕的裁員,這樣割裂的行為背后是因為什么?

于是我們采訪了meta的前FAIR研究總監AI科學家田淵棟、參與了Llama 3后訓練的前meta員工Gavin Wang、硅谷資深HR專家以及一些匿名人士,試圖還原一下meta的Llama開源路線到底發生了什么:

為什么Llama 3還讓眾人驚艷,而僅一年之后的Llama 4就如此拉胯?中間發生了什么?meta的開源路線從一開始就注定是個錯誤嗎?AI大模型激烈對戰的當下,一個烏托邦式的AI研究實驗室還能夠存在嗎?

01 FAIR與GenAI的誕生:meta的AI十年布局與架構搭建

首先來看看meta對AI布局的整個公司架構。

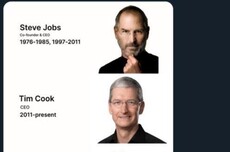

2013年年底,扎克伯格開始搭建meta的AI團隊。當時,谷歌收購了Geoffrey Hinton的DNN團隊,將Hinton招入麾下,同一時間,meta將Yann Lecun請來坐鎮AI的發展。至此,圖靈獎三巨頭的兩位開始步入商業科技來主導AI研發。

在扎克伯格邀請Yann LeCun加入meta的時候,后者提過三個條件:

1.不從紐約搬走;

2.不會辭去在紐約大學的工作;

3.必須開展開放的研究,公開發布所做的所有工作,并將代碼開源。

所以,一開始meta的路線就是開源的。Yann LeCun進入meta之后,開始著手前沿的AI研發,組建了Fundamental AI Research實驗室,也就是大名鼎鼎的FAIR實驗室,主導人工智能的前沿研究。

田淵棟 前meta基礎AI研究(FAIR)團隊研究總監: FAIR是負責前沿研究的,就是做一些現在目前看起來沒有特別大的應用,但是新的想法、新的思路、新的算法、新的框架、新的模型架構。這樣的探索之后可能會有一些大的突破,大概是這樣的一個邏輯。

但是對于meta來說,最終還是要看到AI在自身產品上的進展。于是和FAIR組平行設置了一個組叫“Generative AI”,簡稱“GenAI”組。

這個組里面分別有不同的功能團隊,包括了Llama開源模型的研發,將AI能力運用到產品上的meta AI團隊,還有AI算力基建的數據中心團隊,其它的還有一些小部門,比如說Search(搜索),Enterprise(企業服務),Video-gen(文生視頻)模型等等。

GenAI和FAIR是平行關系,這像是一個天平,一邊是前沿科研,一邊是產品化。理想情況下,前沿研究能帶來更好的產品力,而產品賺錢了能讓管理層有更大的動力撥款給FAIR去做研發。

田淵棟 前meta基礎AI研究(FAIR)團隊研究總監: 比如FAIR會提供一些很好的想法和工作給GenAI去用,讓GenAI把這些想法和工作放進生產,然后在下一代模型中使用出來。 很多人的初心就是說想做一些不一樣的東西,或者是與眾不同的方向、工作。能不能真正地實現AGI(通用人工智能)?這其實是個比較大的問題。

陳茜 硅谷101聯合創始人: 所以FAIR的目的是AGI,但是GenAI它的目的是怎么把AI放在meta現有的產品中,讓AI發生效應。田淵棟 前meta基礎AI研究(FAIR)團隊研究總監: 對,應該說主要一方面是Llama,Llama是一個很大的模型。還有就是怎么樣把AI比較好地用在一些具體的應用上。

但是,讓這樣的天平始終保持平衡,是一個很理想化的烏托邦狀態。而這個烏托邦狀態的前提是,meta的AI模型水平一直是要保持最領先的,或者說,至少是在開源賽道最領先,且不落后閉源模型太多的。

meta AI

陳茜 硅谷101聯合創始人: 你覺得在FAIR最快樂的一段時光是什么時候?田淵棟 前meta基礎AI研究(FAIR)團隊研究總監: 我覺得從我入職FAIR之后一直到2022年,這段時間是很開心的。因為大語言模型來了之后,整個生態或者說研究者之間的關系發生了一些變化。因為大語言模型來了之后,算力成了很重要的一個因素。 因為算力是有限的,所以就會產生各種問題、各種矛盾。大家都要訓練一個很大的模型,如果是這樣的話,相互之間就開始有一些問題,比如說如果我卡多了,你卡就少了。因為卡不多就沒辦法訓練出很好的模型,所以在2023年之后這段時間之內,狀態肯定不會像以前那么好。

而meta的AI天平是如何失衡的呢?我們可以從Llama的四代發布中,看到一些端倪和痕跡。

02 “開源之光”:Llama的昔日驕傲與滑鐵盧?

之所以meta給自家大語言模型取名“Llama”,據說是因為考慮到Large Language Model的縮寫“LLM”不太好發音,所以就補上了元音字母。“Llama”朗朗上口也便于記憶傳播。也正是這樣,大語言模型命名自此才和“羊駝”扯上了關系。

Chapter 2.1 Llama 1:開源的“種子”

我們先來看看Llama 1,這也為meta的大模型“開源”路線奠定了基礎。

2023年2月24日,meta發布Llama模型,主打“更小參數更好效果”(多規模:7B/13B/33B/65B),強調當時的13B模型可以在多項基準上超過175B參數的GPT-3。

而Llama在官宣之后的一周,權重在4chan上以種子形式被“泄露”,引發了AI社區對開源模型的廣泛討論,甚至還引發國會參議員致信質詢meta。

雖然有不少質疑的聲音,但業界對Llama的“意外泄露”出人意料的支持,而這也被視為“大模型開源”的格局重塑,并且很快催生出了諸多的民間微調項目。

我們在這里稍微解釋一下大模型的“開源”定義。其實meta也不是完全的開源。meta稱之為“開放權重”(Open weights)。

在機器學習中,有三個部分:結構(architecture),權重(weights)和代碼(code)。所謂“權重”,就是模型學習到的所有參數數值。模型訓練完成后,所有參數會存成幾個巨大的二進制文件。每個文件里保存著每一層神經網絡的矩陣數值。而在推理時,模型代碼會加載這些權重文件,用GPU進行矩陣運算生成文本。

所以“開放權重”就意味著向公眾提供訓練好的參數文件,外界可以本地加載、部署和微調,但還不是完全的“開源”,因為真正的開源意味著公開訓練數據、代碼和許可等等。但meta并沒有公開這些信息,甚至之后的Llama2、3、4代都僅僅是開放權重,只是在許可證的政策上有些松動。

雖然Llama屬于“半開源”,但比起OpenAI,Anthropic和谷歌完全閉源、只通過API接口來提供模型能力服務的公司來說,已經算給開源社區帶來非常旺盛的生命力了。

Chapter 2.2 Llama 2: 開放“可商用”

2023年7月28日,meta聯合微軟發布了大模型Llama 2,包含7B、13B和70B參數的三種參數變體。

新一代模型的“開源”雖然也是“開放權重”,但對比Llama 1的不可商用、只能申請研究用途而言,Llama 2是一個免費可商用的版本,更放寬了許可證的權限,而Wired等雜志更是指出,Llama 2 讓“開放路線”對抗封閉模型巨頭成為現實。

而我們看到,Llama 2很快在開發者社區風靡起來,它的可得性顯著放大了生態和AI開發。

之后,就到了2024年的Llama 3,這也是Llama系列最為輝煌的時刻。

Chapter 2.3 Llama 3系列: 逼近閉源陣營

步入Llama3的時代,meta已經成為AI開源社區的頂流存在。2024年的4月到9月,meta連發三個版本的模型迭代。

2024年4月18日,meta發布8B、70B兩個規格的Llama 3版本,稱同等規模“顯著超越Llama 2”,并將其作為meta AI助手的底座之一。

之后的7月23日,meta推出405B、70B、8B三檔Llama 3.1模型,并宣稱405B是“全球最強的開放可得基礎模型”之一;同時登陸AWS Bedrock、IBM watsonx等平臺。

僅兩個月之后的2024年9月25日,meta推出Llama 3.2,主打小而全的多模態,新增1B與3B輕量文本模型與1B與90B的視覺多模態模型,面向終端/邊緣場景;AWS等平臺同步接入,開源框架平臺OLlama亦可本地運行。

我們采訪到了Llama 3團隊的Gavin Wang,他負責Llama 3的后訓練工作,對我們表示當時整個meta,GenAI團隊是在以“光速”前進,真的有種“AI一天,人間一年”的感覺。

Gavin Wang 前meta AI工程師,從事Llama 3后訓練: 當時Llama3.1/3.2確實是有很多很好的進展,比如多模態是在這個階段里面發布的,包括后面他們做Lightweight model(輕量化模型)1B/3B的。我覺得這時候產品化生態取得了很大進展,很多的社群都有支持,包括我有朋友在Llama Stack團隊,他們就是專門支持整個Llama的生態在企業級或者說小企業級的落地。

Llama 3的強勢出擊,特別是450B版本被認為是在模型能力上對閉源陣營的逼近,也被認為將快速推動AI應用的落地。而對于meta內部員工來說,特別是在Llama組的AI工程師們,這是一件非常讓他們值得驕傲的項目。

Gavin Wang 前meta AI工程師,從事Llama 3后訓練: 當時的敘事是說,meta是大廠里面唯一一個剩下開源的模型,而且還對整個開源生態很有貢獻。當時我覺得很多人都會覺得,這不僅僅是在做一份工作,而是我們真的就是在支持整個AI的前沿的發展,你做的每一件事情都感覺非常有意義,我當時是非常自豪的感覺。我出去跟別人說,我是在做Llama 3的團隊,一些創業公司的創始人他們都會說:非常感謝你的努力。感覺整個技術圈,尤其是AI創業圈,都在指望Llama。

meta乘著東風,期望Llama 4的發布,能進一步的擴大自身在AI開發社區的影響力,保持“頂尖大模型中的唯一開源存在”。

扎克伯格在2025年1月底財報會議后發帖說,“我們對Llama 3的目標是使開源與封閉模型具有競爭力,而我們對Llama 4的目標是領先。”

然而,三個月之后的Llama 4發布,卻是一場徹底的災難和滑鐵盧。

Chapter 2.4 Llama 4: 滑鐵盧

2025年4月5日,meta推出Llama 4的兩個版本(Scout與Maverick),宣稱多模態與長上下文能力大幅躍進,并在宣傳中高調引用LMArena排行榜上的領先成績:Maverick版本僅次于Gemini 2.5 Pro,與ChatGPT 4o和Grok 3 Pro并列第二。

然而很快,開發者社區的反饋并不正面,認為Llama 4的效果不及預期。市面上開始有流言質疑meta在LMArena上沖到第二名的版本有作弊嫌疑,懷疑Llama 4給LMArena排名的是經過了優化的變體,而這個變體經過了對話強化的訓練,存在誤導LMArena、導致過擬合的現象。

雖然meta高層迅速否認了作弊,但影響迅速發酵,一方面,媒體紛紛將此視為“用特調版本刷榜”的“誘餌換包”(bait-and-switch),行業對基準公信力與可復現性的討論升溫;另一方面,meta更高端的Behemoth版本推遲發布,公關與節奏嚴重受挫。

截至目前,Behemoth還沒有發布,meta應該是放棄了。

接下來就是大家所知道的,扎克伯格開始孤注一擲的大手筆收購Scale AI,把Alexander Wang挖過來領導新的AI架構,之后用上億美元的支票開始挖人,瘋狂攪局硅谷AI人才市場。

再之后就是最近的新聞,Alex開始重組整個meta的AI架構,裁掉600人。

但大家看看這個時間線,是不是還是覺得很割裂,在Llama 3和Llama 4的這一年中,發生了什么?怎么Llama 4一下子就不行了?這是不是也太快了。

我們通過復盤,也許找到了一些答案。還記得我們在前文提到,meta內部的AI架構是一架天平嗎?Llama 4失敗的原因就是:這架天平失衡了。

03 失衡天平:前沿研究與商業化的路線之爭

在meta的AI架構中,FAIR和GenAI是并行的兩個組,Yann Lecun管FAIR,但Yann LeCun很多時候沉浸在自己的研發中,有時候還在網上跟人,比如說馬斯克對戰,還經常說不看好LLM路線,讓meta很頭疼。

于是,2023年2月,meta高層把meta AI的研究負責人Joelle Pineau調到FAIR,擔任FAIR的全球負責人,與Yann LeCun兩人一起領導FAIR。

Bussiness Insider

而GenAI的負責人是Ahmad Al-Dahle,這個哥們兒之前在蘋果工作了快17年,而扎克伯格把他挖過來的原因,就是想把AI和meta的各種產品結合起來,包括元宇宙,智能眼鏡的AI整合,以及聊天工具meta.ai等等。

而就在經歷了Llama 2的成功,公司開始研發Llama 3的過程中,meta高層越來越強調“要將AI用于自家產品”的屬性。

于是我們看到,2024年1月,meta的AI團隊進行了一次重組,FAIR的兩名負責人開始直接匯報給meta的CPO(首席產品官)Chris Cox。

Gavin Wang 前meta AI工程師,從事Llama 3后訓練: 整個Llama 1 ~ 3算是一個時代,大家很瘋狂地在卷scaling law(縮放法則),當時整個行業里都在追隨基礎模型的能力的提升。大家在探索基礎模型、大語言模型本身的能力的邊界。但是meta的領導層, 像扎克伯格和CPO Chris Cox,他們其實很早就意識到大語言模型的能力能夠落地,能真正為社會產生價值,他們肯定是從產品力上去出發的。所以說當時Llama 2和Llama 3的階段,整個GenAI的核心目標是讓研究成果真正產品化、工程化。也因此就是在最高管理層層面,包括副總裁、高級總監的高層,是由一些之前更多的是產品背景和工程背景的人來領導的。

在Llama 3成功推出,meta高層開始制定Llama 4的路線之際,所有的注意力都放在了與產品結合上,也就是多模態能力,因此忽視了對模型推理能力上的重視。

而就在Llama 3到Llama 4的這一年研發過程中,2024年9月12日,OpenAI推出了基于思維鏈的o1系列模型,之后的2024年12月,中國的deepseek開源模型橫空出世,用MOE混合專家架構在保證推理能力的情況下大幅度降低了模型成本。

陳茜 硅谷101聯合創始人: 你在被拉去救火Llama 4之前,手上在研究什么?田淵棟 前meta基礎AI研究(FAIR)團隊研究總監: 我們這邊在做一些關于推理的一些研究。主要是關于思維鏈,包括思維鏈的形態和訓練的方式做了一些研究。o1是去年9月份出來的,其實我們在o1出來之前,就注意到非常長的思維鏈會對整個模型的scaling law(縮放法則)產生影響。

arxiv

其實FAIR組中,田淵棟等研究員已經在著手思維鏈的研究,但這樣對推理能力的前沿探索并沒有及時傳達到Llama模型的工程上。

Gavin Wang 前meta AI工程師,從事Llama 3后訓練: Llama 4規劃的時候,就會感覺到這個地方可能領導層的方向有一些變化。我認為總體來說他們還是想要支持meta本身重點去推的一些產品,就是Llama本身的生態,多模態肯定是其中的一個重點。但是DeepSeek在1月份的時候橫空出世,它們的推理能力非常的強。推理能力在當時也是討論的其中一個方向,但是因為meta本身的生態,它們更看重多模態,沒有重點去做推理。但是當DeepSeek出現了以后,那時我實際上已經離開了Llama的團隊,不過據說當時他們有在討論說是不是要重新把推理的地方撿起來,但這個地方可能優先級上有一些沖突,加上時間也非常的有限,就導致大家加班加點地做了很多的嘗試,非常得忙。我覺得DeepSeek的出現肯定是造成了公司里面資源還有優先級管理上的一些混亂。還有一點,我覺得Llama 1~3整個模型的架構和組織的架構,是延續了一開始的設計。但是因為Llama 3的成功,大家就希望Llama 4能夠更進一步,能夠做一些更大的工程。那這個時候可能出現了一些問題,我的觀察就是公司比較高層的,像副總裁、資深總監這個層面,他們很多人是比較傳統的基礎架構、計算機視覺背景,可能自然語言處理背景的都比較少。所以可能他們技術層面對于AI原生技術或者是大語言模型這些東西就沒有一個深度的理解和認識。真正懂行的,可能是下面具體做事的一些博士,尤其是我們非常驕傲的是,華人的博士都是技術非常扎實的。但是他們獲得的話語權,或者說在公司內部的資源沒有那么多。所以說可能不知什么緣故就造成一種外行管理內行的一些局面出現。

DeepSeek

因為OpenAI的o1系列和DeepSeek的出現,讓meta在2025年年初亂了陣腳。于是,高層臨時讓FAIR的研究團隊去支援Llama 4的研發,或者可以直接說是去“救火”,而這個“救火團隊”就是田淵棟帶隊的。

田淵棟 前meta基礎AI研究(FAIR)團隊研究總監: 我覺得現在很大的一個教訓就是,做這樣的項目不能讓不懂的人來做整個的領導者或者做整個的規劃。如果有些東西出了問題的話,應該是大家說:ok,我們不能在這個時候發布,我們再往后拖。應該是采用一種,我拖到什么時候結束能夠正常運作才發布的階段。而不能說把deadline先定好,不然的話有很多事情是做不好的。我覺得我們組里面當時很多人非常累,比如說像我是在加州,因為我有幾個團隊成員在東部時區,他們晚上12點給我打電話,他們那邊已經3點鐘了,還在干活,所以非常的辛苦。為什么他們那么辛苦呢?是因為deadline壓得很緊。比如說我們的deadline就是要計劃在某一天要發布,項目管理就需要從后往前倒退,然后看2月底或者3月初一定要做什么事情、3月底要做什么事情。但如果你在做這些事情的時候,你發現這個模型這方面不行,或者說數據有什么問題,在這種情況下,我覺得有一個很大的問題就是,你怎么樣能夠讓大家因為你這句話停下來。就比如說,我說這個數據有問題,不行,我這個數據不能用,我們得換一個數據。那這樣的話就多出事了,我們得把整個事情往后延一個星期、兩個星期。但這個事情能不能做到是一個很大的問題。如果在很強的deadline壓力之下,最后結果就是這事情做不了,或者說大家沒有辦法去提出異議,那這樣的話最后的質量就會變得很差。這是一個比較大的問題。陳茜 硅谷101聯合創始人: 為什么meta會有那么強的壓力在deadline上面呢?因為開源模型,其實它已經是第一了。當然,DeepSeek在年初的時候出來,大家都沒有意料的到。但是為什么它有那么強的deadline說我一定要在這個時候把這個東西推出來?田淵棟 前meta基礎AI研究(FAIR)團隊研究總監: 應該說有個上面高層定下的deadline,但這個我就不方便說了,可能能你要去問一下相關的人,懂的都懂。

meta

我們在這里基本上能有一些答案了,從Llama 3開始,“將AI產品化”這樣的路線就已經制定,整個模型注重多模態和應用、忙于整合應用和業務,但卻忽略了推理和更前沿的技術研發。這讓天平另一邊的FAIR團隊不得不跨組來“救火”,就這樣,天平失衡了。

田淵棟 前meta基礎AI研究(FAIR)團隊研究總監: 但實際情況其實是因為前沿模型的競爭太激烈了,所以基本上很難真的去用FAIR這邊的一些文章。雖然有些文章是被用到了,但是我們在交流的過程中還是會存在一些問題。我當時就是在FAIR的時候,我有時候Ping(發信息給)GenAI的人,他們都不理我,這是什么情況?但是真的我去了GenAI之后我會覺得,確實我也沒法理他們(FAIR研究員們)。因為太忙了,比如說我半小時不看手機,可能就有20條、30條的消息要去看,有很多的人要找,有很多的事情要決定。所以我也能理解了,在GenAI這樣的環境下,很難有比較長期的思考過程。

而扎克伯格是如何修復這個失衡的天平呢?他直接空降了一個特種部隊:由Alex Wang帶隊的TBD團隊。

04 空降“新王”:28歲Alex Wang獲“無限特權”

meta的AI業務架構如今再一次重組之后,高層也經歷了一系列的動蕩。

Alex Wang帶領幾十位高薪聘請來的頂級研究員,單獨成立了這個在meta內部擁有無限特權和優先級別的特別小組TBD。TBD,FAIR和GenAI一起組成meta Superintelligence Labs(MSL部門),直接匯報給Alex,而Alex直接匯報給扎克伯格。

這也意味著,FAIR的Yann LeCun如今也匯報給Alex,而Joelle Pineau此前被要求匯報給GenAI組的負責人Ahmad。

我們看到,Joelle已經在今年5月離職,去了Cohere做首席AI官;而Ahmad說實話已經很久沒有什么聲音了,也沒有被任命負責任何重要的項目;而CPO Chris Cox也被Alex搶了風頭,排除在了AI團隊的直接領導者之外。

所以現在的架構就是,28歲的Alex一人獨大的局面。

我們聽到過meta內部各種對Alex和他領導的這支極度有特權小組的不滿,包括TBD團隊里的人可以三年不用做績效考評、可以不理不回其它任何VP的信息、meta AI的所有paper都要給TBD里面的人去審核才能給發表。

要知道,TBD里面不少人比較年輕,這是讓很多資深的研究員非常不滿, 反正就是各種內部政治斗爭感覺又要起來一波。

但不可否認的是,特權的等號后面是成績。這個成績對于扎克伯格來說,不僅僅是Make Llama Great Again(讓meta再次偉大),而是“meta has to win”(meta必須贏)。

在這場AI競賽中,目前的這場重組,也許對于扎克伯格來說是最后的一次,也是最重要的機會。而Alex在團隊內部郵件中就寫到他將做出的三個改變:

1.集中TBD和FAIR團隊的核心基礎研究力量;

2.提升產品和應用研發的融合、且繼續以產品為模型聚焦點;

3.成立一個核心基建團隊來支持研究押注。

Tom Zhang 硅谷資深人才專家: 第一條就是把基礎研究、TBD Lab和FAIR更集中化,就讓它兩個更緊密的去結合。所以這回裁掉的一些研究人員,郵件上也說,可能他們的項目沒有那么高的影響力。你再做一些前沿的研究,但和我們現在沒有關系,因為很多前沿研究是高度抽象的,是從數學的角度,從很多理論的角度,它其實和工程的離得比較遠。第二個就是把產品和模型更緊密地結合,和Alex Wang一起進來的人,有一個就是GitHub的原來CEO。等于扎克伯格同時引進了兩個高端人才,一個是Alex Wang,統一來說就是管模型的;一個GitHub前CEO Nat Friedman,他是偏產品的,因為產品才能給這個模型更好的反饋,在用的過程中進行飛輪效應。 第三條是組建一個統一的核心基礎設施(Infra)團隊,就把管卡的數據中心團隊更集中化。過去很可能是很散的,好幾個領導都在,你要卡你得來申請。現在卡這個事也是統一來管理。所以這個郵件寫得還是挺清楚的。

而Alex能否撐得起扎克伯格的押注呢,也許很快我們就會有答案。

Bussiness Insider

總結一下,meta在Llama前三代都還是領先的開源模型,引領著開源派去對抗OpenAI和谷歌Gemini這樣的閉源派。

然而,在Llama 3大獲成功之后,公司高層急于將AI結合產品化,在規劃路線的時候用“產品驅動研發”的思維,將Llama 4的升級聚焦在多模態等工程性能上,但卻錯失了思維鏈(CoT)等推理上的前沿技術時間優勢。

雖然當時田淵棟等FAIR的AI科學家已經在研究CoT了,等DeepSeek引發轟動之后,又將FAIR的田淵棟團隊臨時救火優化Llama 4上的MoE架構,反而又中斷了CoT和推理上的研發,導致AI前沿技術研究和產品工程這架天平徹底失衡。

在采訪過程中,我腦中不止一次閃過歷史上那些閃耀一時的前沿實驗室:貝爾實驗室、IBM Watson Research、HP實驗室等等,但基本都因為無法平衡前沿科研和商業化而日益衰落,十多年歷史的FAIR,曾經是一群理想化AI科學家的烏托邦之地,而如今又成了另一個商業化的犧牲品。

你認為這場由Llama 4失敗引發的大重組,是meta AI的最后機會嗎?歡迎在評論區留言告訴我們。

京公網安備 11011402013531號

京公網安備 11011402013531號